このパッケージはCRANE-X7 ROS 2パッケージのサンプルコード集です。

- crane_x7_examples

CRANE-X7本体をPCに接続します。 接続方法は製品マニュアルを参照してください。

※CRANE-X7本体が接触しないように、十分なスペースを確保してください。

USB通信ポートの設定についてはcrane_x7_controlの

README

を参照してください。

正しく設定できていない場合、CRANE-X7が動作しないので注意してください

次のコマンドでmove_group (crane_x7_moveit_config)と

controller (crane_x7_control)を起動します。

ros2 launch crane_x7_examples demo.launch.py port_name:=/dev/ttyUSB0RealSense D435マウンタを搭載している場合は次のコマンドを実行します。RealSense D435が起動し、camera_linkがロボットモデルに追加されます。

ros2 launch crane_x7_examples demo.launch.py port_name:=/dev/ttyUSB0 use_d435:=true次のコマンドでmove_group (crane_x7_moveit_config)と

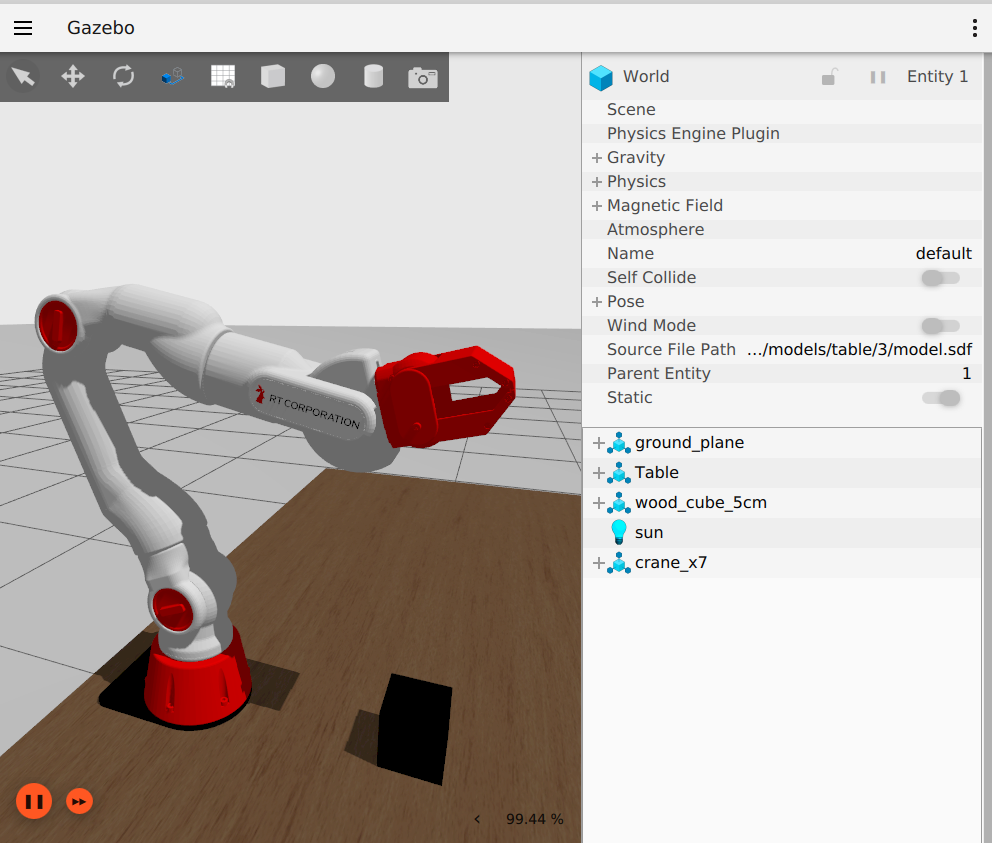

Gazeboを起動します。

ros2 launch crane_x7_gazebo crane_x7_with_table.launch.py次のコマンドでmove_group (crane_x7_moveit_config)と

controller (crane_x7_control)を起動します。

ros2 launch crane_x7_examples demo.launch.py use_mock_components:=trueMock Componentsではカメラを使ったサンプルを実行することはできません。

準備ができたらサンプルプログラムを実行します。 例えばグリッパを開閉するサンプルは次のコマンドで実行できます。

ros2 launch crane_x7_examples example.launch.py example:='gripper_control'終了するときはCtrl+cを入力します。

Gazeboでサンプルプログラムを実行する場合はuse_sim_timeオプションを付けます。

ros2 launch crane_x7_examples example.launch.py example:='gripper_control' use_sim_time:='true'demo.launchを実行している状態で各サンプルを実行できます。

実行できるサンプルの一覧は、example.launch.pyにオプション-sを付けて実行することで表示できます。

$ ros2 launch crane_x7_examples example.launch.py -s

Arguments (pass arguments as '<name>:=<value>'):

'example':

Set an example executable name: [gripper_control, pose_groupstate, joint_values,pick_and_place, cartesian_path]

(default: 'pose_groupstate')ハンドを開閉させるコード例です。

次のコマンドを実行します。

ros2 launch crane_x7_examples example.launch.py example:='gripper_control'group_stateを使うコード例です。

SRDFファイルcrane_x7_moveit_config/config/crane_x7.srdf

に記載されているhomeとverticalの姿勢に移行します。

次のコマンドを実行します。

ros2 launch crane_x7_examples example.launch.py example:='pose_groupstate'アームのジョイント角度を1つずつ変更させるコード例です。

次のコマンドを実行します。

ros2 launch crane_x7_examples example.launch.py example:='joint_values'Cartesian Path を生成し、手先で円を描くコード例です。

次のコマンドを実行します。

ros2 launch crane_x7_examples example.launch.py example:='cartesian_path'モノを掴む・持ち上げる・運ぶ・置くコード例です。

次のコマンドを実行します。

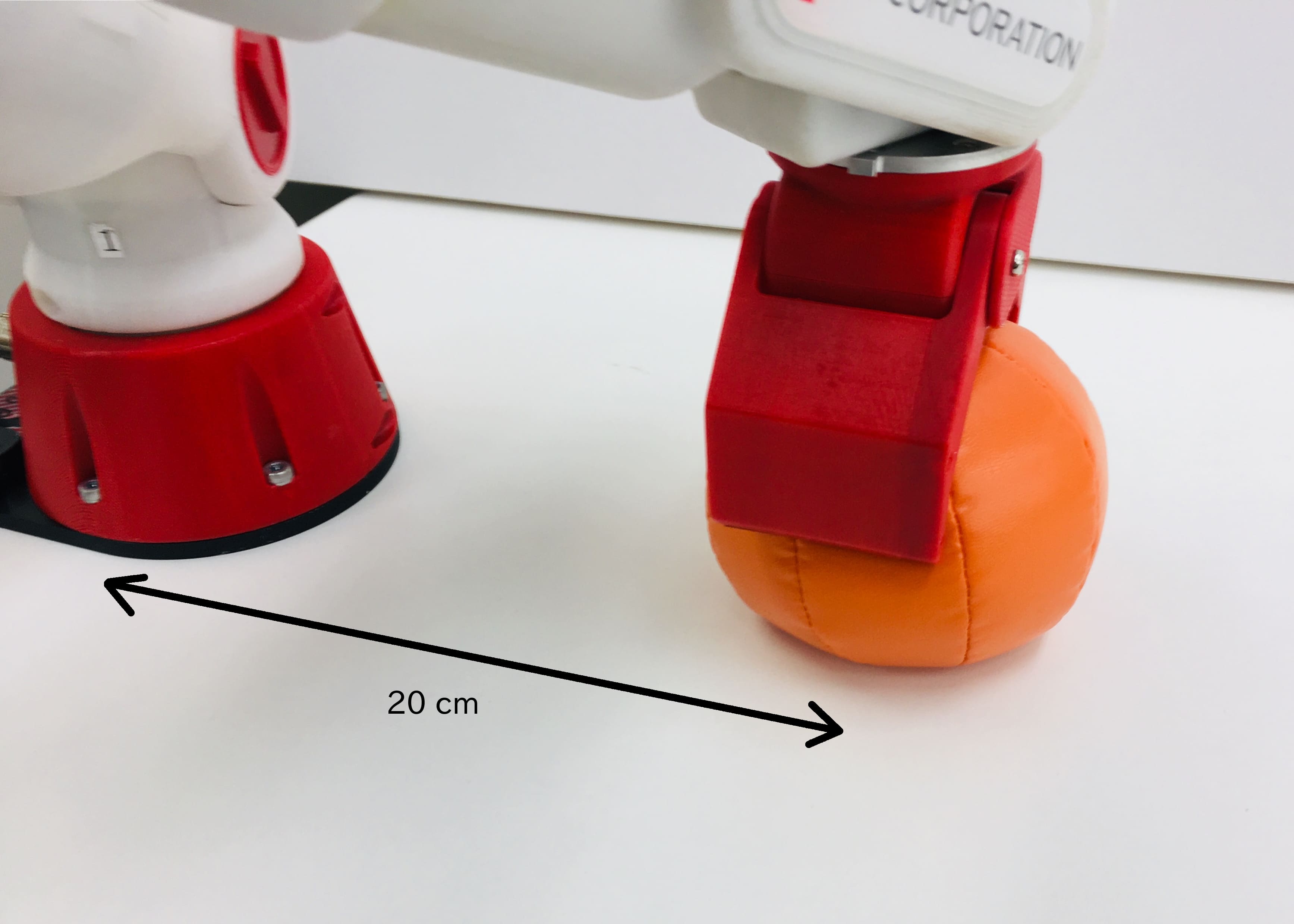

ros2 launch crane_x7_examples example.launch.py example:='pick_and_place'実機を使う場合

CRANE-X7から20cm離れた位置にピッキング対象を設置します。

サンプルで使用しているこのオレンジ色のソフトボールはRT ROBOT SHOPのこちらのページから入手することができます。

RealSense D435マウンタ搭載モデルのカメラを使用したサンプルコードです。

「RealSense D435マウンタ搭載モデルを使用する場合」の手順に従ってdemo.launchを実行している状態で各サンプルを実行できます。

実行できるサンプルの一覧は、camera_example.launch.pyにオプション-sを付けて実行することで表示できます。

$ ros2 launch crane_x7_examples camera_example.launch.py -s

Arguments (pass arguments as '<name>:=<value>'):

'example':

Set an example executable name: [aruco_detection, point_cloud_detection]

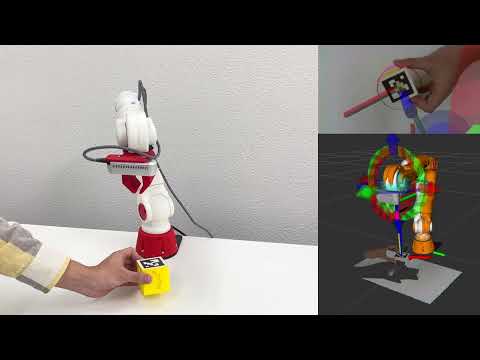

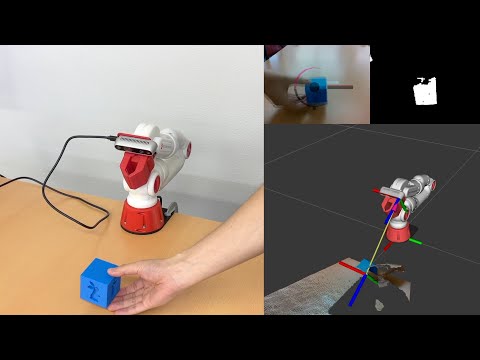

(default: 'aruco_detection')モノに取り付けたArUcoマーカをカメラで検出し、マーカ位置に合わせて掴むコード例です。 マーカはaruco_markers.pdfをA4紙に印刷し、一辺50mmの立方体に取り付けて使用します。

検出されたマーカの位置姿勢はtfのフレームとして配信されます。

tfのframe_idはマーカIDごとに異なりID0のマーカのframe_idはtarget_0になります。掴む対象はtarget_0に設定されています。マーカ検出にはOpenCVを使用しています。

次のコマンドを実行します

ros2 launch crane_x7_examples camera_example.launch.py example:='aruco_detection'特定の色の物体を検出して掴むコード例です。

デフォルトでは青い物体の位置をtfのフレームとして配信します。

tfのframe_idはtarget_0です。

色の検出にはOpenCVを使用しています。

検出した物体の距離は深度画像から取得します。

次のコマンドを実行します

ros2 launch crane_x7_examples camera_example.launch.py example:='color_detection'点群から物体を検出して掴むコード例です。

検出された物体位置はtfのフレームとして配信されます。

tfのframe_idは検出された順にtarget_0、target_1、target_2…に設定されます。掴む対象はtarget_0に設定されています。

物体検出にはPoint Cloud Libraryを使用しています。

次のコマンドを実行します

ros2 launch crane_x7_examples camera_example.launch.py example:='point_cloud_detection'